Este es el primero de una serie de artículos relacionados con la Astronomía y la Evolución de la Ciencia. Veremos cómo los hechos que se van sucediendo, aportan lo necesario para los grandes cambios en la ciencia y la tecnología.

Un modelo mecanicista-legalista para un mundo:

Los modelos cosmológicos anteriores al siglo XVII, adolecían de un modelo físico que los sustentara, una teoría cosmológica como la propuesta por Copérnico, era difícil de sustentar con la física aristotélica.

La nueva cosmología requería de una nueva física, que comenzó a desarrollar Galileo y completó Newton en la segunda mitad del siglo XVII. Y es aquí donde vamos a comenzar nuestra historia.

La nueva cosmología requería de una nueva física, que comenzó a desarrollar Galileo y completó Newton en la segunda mitad del siglo XVII. Y es aquí donde vamos a comenzar nuestra historia.

A partir de un modelo mecanicista-legalista, aparece la revolución científica del siglo XVII. Esta revolución tenía algunos ingredientes:

-

La valoración de la naturaleza

-

La concepción de un orden legal expresable matemáticamente bajo una estructura mecánica

-

Inauguración de un modelo de cientificidad por el recurso matemático por asemejar a la naturaleza a un mecanismo (mecanicismo), ya que la naturaleza era comparable a una máquina.

-

Los cambios revolucionarios produjeron la introducción de modelos matemáticos.

Había solamente un problema: encontrar un método adecuado para indagar a la naturaleza, hubo entonces que hacer una revisión del conocimiento humano; en ese momento las dos líneas de pensamiento más destacadas eran:

-

El pensamiento racionalista (Descartes), cuya base era, que la fuente del conocimiento era la razón.

-

El pensamiento empirista (Hobbes), que sostenía que la fuente del conocimiento residía en los sentidos. De este pensamiento, surgen luego dos movimientos importantes como lo fueron el Positivismo del siglo XIX y el neopositivismo del siglo XX.

El surgimiento de un Modelo Contemporáneo:

Todo surgimiento de modelos científicos, tienen una razón de ser, y esta vez, entra en crisis la visión mecanicista del mundo, claramente llegando al siglo XIX, el panorama de la ciencia cambia, la relación entre la filosofía y la ciencia también. Es la época de la profesionalización de la ciencia, la Ilustración y la Revolución Francesa, condujeron a la institucionalización y profesionalización estricta entre científicos.(1) Como resultado de esta época, se produce la unión entre la enseñanza de las ciencias y los diseños de investigación. Por lo cual habrá una comunidad científica profesionalizada, estable, comunicada y definida.

Nuevos dominios en el campo de la ciencia afloran en estos tiempos, la Física, la Química, la aplicación de la teoría a la experimentación, la Biología Evolucionista Darwiniana, surgen las Ciencias Sociales, se separan la Filosofía de la Ciencias, nacen las Geometrías No Euclídeas.

Pero volviendo a nuestro problema en sí que era el motivo por el cual entra en crisis el modelo mecanicista, la razón válida para esta crisis, fue por lo tanto, el desarrollo y distanciamiento de las ciencias entre sí, que adquieren a partir de ese momento pautas autónomas. Los problemas concretos por los cuales aparece esta crisis, fueron entre otros:

-

Problemas del éter y el concepto de campo: para estos tiempos se integran los conceptos de electricidad y magnetismo, este fue un duro golpe al mecanicismo. Físicos como Maxwell, Faraday, Michelson, Marley, estaban realizando sus aportes a la ciencia.

El Electromagnetismo:

La construcción de una teoría sobre la naturaleza de la luz creó innumerables problemas de carácter teórico para la física del siglo XIX. A la altura de 1850 dos teorías contradictorias, la corpuscular y la ondulatoria, aparentemente incompatibles entre sí, pugnaban por explicar la naturaleza de la luz. Las dificultades se acrecentaban de manera notable a la hora de encontrar una manera satisfactoria de explicar los fenómenos eléctricos y magnéticos, provocando una importante división entre los partidarios de una y otra teoría que termino por desembocar en la construcción de una electrodinámica.

Con la llegada de James Clerk Maxwell la situación cambió radicalmente. Inspirándose en los trabajos de Michael Faraday, estableció la teoría unificada de los fenómenos eléctricos y magnéticos, para lo cual postuló la existencia del éter, que ocupando todo el espacio, se constituye en el medio en el que se desarrollan los fenómenos electromagnéticos. Además, Maxwell afirmaba que la luz era un fenómeno electromagnético más, por lo que la óptica debía ser considerada bajo la perspectiva de la electrodinámica y, por tanto, debía ser incluida en una teoría electromagnética que abarcará los fenómenos ópticos.

Con la llegada de James Clerk Maxwell la situación cambió radicalmente. Inspirándose en los trabajos de Michael Faraday, estableció la teoría unificada de los fenómenos eléctricos y magnéticos, para lo cual postuló la existencia del éter, que ocupando todo el espacio, se constituye en el medio en el que se desarrollan los fenómenos electromagnéticos. Además, Maxwell afirmaba que la luz era un fenómeno electromagnético más, por lo que la óptica debía ser considerada bajo la perspectiva de la electrodinámica y, por tanto, debía ser incluida en una teoría electromagnética que abarcará los fenómenos ópticos.

Maxwell en su fundamental obra Treatise on Electricity and Magnetism, publicada en 1873, aunque no tenía muy claro como interpretar las ecuaciones de campo por él formuladas, independizó las mismas de toda analogía mecánica, proponiendo una teoría de campos. Aunque ello no supuso una ruptura de Maxwell con la teoría newtoniana, en tanto que trató de demostrar que su teoría era consistente con la existencia de un mecanismo newtoniano en el campo, al fin y al cabo los resultados por él alcanzados cuestionaban radicalmente la posibilidad de una explicación mecánica del campo.

A raíz de la aparición de la teoría electromagnética de Maxwell, se fue abriendo camino una nueva representación de la Naturaleza: la representación electromagnética, especialmente desde la aparición de los trabajos de Hertz en 1887-88, en los que exponía sus experimentos, que demostraban la existencia de la radiación electromagnética(3). Los trabajos de H. A. Lorentz que culminaron con la aparición de la teoría electrodinámica de los cuerpos en movimiento, en 1892, no hicieron sino acrecentar el prestigio y el número de seguidores de la representación electromagnética de la Naturaleza en detrimento de la representación mecanicista.

-

La Irreversibilidad y la Mecánica Estadística: la Teoría Cinética de los Gases a través de la 2º Ley de la Termodinámica, nos habla de la irreversibilidad de los procesos térmicos.

-

La Radiación térmica y el concepto de Energía: el gran desafío era para entonces, encontrar la fórmula de distribución de la energía según las longitudes de onda. Había que pensar en una Energía no continua sino cuantificada, argumento que no encajaba en los supuestos mecanicistas.

Claro está que la crisis se produce porque las restricciones impuestas a la ciencia por el sentido común (mecanicismo-materialista), estaban siendo violadas.

Veamos cuál es la Explicación de Radiación Térmica y Energía que se estaba trabajando:

La Representación determinista del mundo:

Ahora bien, conforme la teoría electromagnética se iba imponiendo en los círculos científicos del último tercio del siglo XIX, surgieron voces que reclamaban una revisión crítica de los fundamentos de la Física clásica orientada a eliminar los elementos metafísicos que habían contaminado la Física teórica desviándola, a su juicio, de su verdadero carácter de ciencia empírica.

Veamos qué significa esto: Ya corriendo los primeros tiempos del siglo XX, la Filosofía Moderna tomaba matices distintos, el Círculo de Viena, un grupo de científicos empiristas lógicos que consideraban que la única interpretación del mundo era la científica, rechazaban por lo tanto, las interpretaciones religiosas y metafísicas. Sus bases del conocimiento humano eran absolutamente empiristas, y creyeron en la construcción de un lenguaje unificado y común a todas las ciencias, ajeno a las imperfecciones del lenguaje ordinario. La de los enunciados científicos para los empiristas lógicos, debía ser aquellos que pudiesen verificarse en la medida que se correspondían con los hechos o las observaciones científicas, y que concordaran con las predicciones de la ciencia, ya que la única fuente de conocimiento era la experiencia sensible. De aquí, que el foco de observación en esta época fue el lenguaje, el proyecto era reducir todas las proposiciones observables a un lenguaje fisicalista, de allí que su principal característica fue el giro lingüístico.

El siglo XIX estuvo así, marcado por discursos ambiguos, y discursos exactos, entre el dogma y la crítica, entre lo físico y lo metafísico, dentro de los discursos ambiguos estaban por un lado los descubrimientos y el avance tecnológico, y por otro lado el perfil del romanticismo, con su desconfianza en la razón. Dos fueron las corrientes que sobresalieron en este período: el sensacionismo de Ernst Mach, cuyas posiciones se acercan bastante a una fenomenología de la ciencia, sobre todo en sus escritos histórico-críticos sobre Física, y el energetismo, cuyo máximo exponente fue el químico William Ostwald.

Ambas corrientes se enfrentaron con empeño a la representación mecanicista de la Naturaleza, y en particular a las hipótesis atomísticas. Los fenomenistas rechazaban toda hipótesis que no se fundamentara directamente en la experiencia, eran, por tanto, defensores de un positivismo extremo, de ahí la influencia que ejerció Ernst Mach en los fundadores del Círculo de Viena y del neopositivismo. El energetismo trataba de construir una concepción metateórica que liberara a la ciencia de su dependencia respecto de la

Física, mediante el desarrollo de una ciencia superior, la energética, que unificara en ella el resto de las ciencias. La justificación de dicha pretensión la encontraban en el enorme desarrollo y éxitos que el tratamiento de la energía había deparado durante la segunda mitad del siglo XIX en la Física y en la Química.

De hecho, Mach lo que pretendía era re-fundar la mecánica newtoniana sobre la base de unos nuevos presupuestos descriptivo-analíticos desposeídos de todo vestigio de carácter metafísico. Lo que Mach persigue es eliminar todo rastro de razonamiento deductivo de carácter metafísico-filosófico de la mecánica newtoniana, no su verdad de hecho, ni siquiera pretendía acabar con sus presupuestos epistemológicos intrínsecos. En cualquier caso, desde la crítica machiana no era posible destruir, ni Mach pensaba en ello, la episteme clásica. Tuvo que desarrollarse la revolución relativista y cuántica para que de la crisis se pasara a la revolución de los fundamentos, esto es, a la destrucción de los presupuestos epistemológicos básicos que habían configurado la episteme clásica, razón de ser de las formas del pensar que han dominado la cultura occidental desde hace tres siglos.

Einstein y la Teoría de la Relatividad

En sus Notas Autobiográficas, Einstein explícita el origen de la Teoría Especial de la Relatividad en la necesidad de encontrar un principio formal y general que condujese a resultados seguros capaces de dar respuesta a los problemas enunciados. Einstein modificó radicalmente, con la Teoría Especial de la Relatividad, la forma de ver la física, al establecer que "no existía ninguna incompatibilidad entre el principio de relatividad y la ley de la propagación de la luz", a través de una nueva formulación de los conceptos de Espacio y Tiempo.

Para ello recurrió a una nueva definición del concepto de simultaneidad, según la cual "Cada cuerpo de referencia (sistema de coordenadas) tiene su tiempo especial; una localización temporal tiene sólo sentido cuando se indica el cuerpo de referencia al que remite".

Para ello recurrió a una nueva definición del concepto de simultaneidad, según la cual "Cada cuerpo de referencia (sistema de coordenadas) tiene su tiempo especial; una localización temporal tiene sólo sentido cuando se indica el cuerpo de referencia al que remite".

Desaparece así el tiempo absoluto característico de la Mecánica clásica: deja de ser necesario para la Física y se convierte en un elemento superfluo que estorba ahora a la propia teoría física. La ruptura con la física clásica aparece aquí evidente. Otro tanto ocurre con el concepto de espacio absoluto, el concepto de distancia espacial entre dos puntos de un cuerpo rígido se encuentra en función del sistema de referencia y sólo en este sentido puede ser empleado en Física. La reinterpretación de Einstein de las ecuaciones de transformación de Lorentz permitió establecer la transformación de las magnitudes espacio-temporales de un suceso al pasar de un sistema de referencia a otro. Einstein señalaba así su carácter de grupo, que no exigía la existencia de un sistema inercial privilegiado, diferente de los demás sistemas por su estado de reposo (espacio absoluto).

Claro que esto que parecía tan sencillo a primera vista, suponía el fin de la vieja ilusión mecanicista, con lo que todo el edificio de la Física clásica, que tantos esfuerzos había costado levantar, se tambaleaba peligrosamente. Estas son las razones que explican la incapacidad de Lorentz para interpretar correctamente las ecuaciones de transformación que él mismo había descubierto, atrapado como estaba por la epistemología de la Física clásica, de manera similar Poincaré no llegó a generalizar su principio de relatividad. Tuvo que ser Einstein quien cortase con la teoría newtoniana, haciendo desaparecer de la faz de la Física el espacio y el tiempo absolutos newtonianos.

La aparición de la Teoría Especial de la Relatividad provocó la ruptura de la estructura armónica y totalizadora de la cosmovisión procedente de la física clásica, según la cual las leyes de la Mecánica daban razón de la totalidad del Universo, constituyéndose en Leyes Naturales de carácter universal. La desaparición de un sistema de referencia privilegiado, constituido sobre la base de la existencia de un espacio y tiempo absolutos, eliminaba la posibilidad de establecer, bajo las premisas de la antigua  física clásica, una teoría física que unificase, mediante el establecimiento de unas Leyes Generales, el funcionamiento de la Naturaleza, situación que se agravaría con el desarrollo de la Mecánica Cuántica durante el primer tercio del siglo XX, y que en la actualidad todavía no ha podido ser resuelta a pesar de los esfuerzos teóricos desarrollados con el fin de dar con una teoría unificada, en la que se ensamblen los resultados alcanzados por la Relatividad y la teoría cuántica. Ya vemos entonces cómo cada nueva teoría, produce una revolución, un nuevo pensamiento, una nueva manera de concebir a la naturaleza.

física clásica, una teoría física que unificase, mediante el establecimiento de unas Leyes Generales, el funcionamiento de la Naturaleza, situación que se agravaría con el desarrollo de la Mecánica Cuántica durante el primer tercio del siglo XX, y que en la actualidad todavía no ha podido ser resuelta a pesar de los esfuerzos teóricos desarrollados con el fin de dar con una teoría unificada, en la que se ensamblen los resultados alcanzados por la Relatividad y la teoría cuántica. Ya vemos entonces cómo cada nueva teoría, produce una revolución, un nuevo pensamiento, una nueva manera de concebir a la naturaleza.

La Teoría de la Relatividad General planteaba una nueva configuración del Universo, a partir de la nueva geometría del continuo espaciotemporal de carácter no euclideo. El Universo infinito y estático característico de la cosmología clásica se ve obligado a ceder el paso a una nueva representación: el Universo finito y dinámico de la Relatividad General. Einstein se vio obligado a abandonar la geometría euclidea como marco en el que se desenvuelve el espacio-tiempo bajo la acción de un campo gravitatorio, rompiendo radicalmente con la representación espacial de la física clásica. Einstein recurrió a la utilización de coordenadas gaussianas como el método adecuado a medidas -distancias- no Euclídeas, características del continuo espacio-temporal bajo el efecto de un campo gravitatorio.

La Teoría de la Relatividad General planteaba una nueva configuración del Universo, a partir de la nueva geometría del continuo espaciotemporal de carácter no euclideo. El Universo infinito y estático característico de la cosmología clásica se ve obligado a ceder el paso a una nueva representación: el Universo finito y dinámico de la Relatividad General. Einstein se vio obligado a abandonar la geometría euclidea como marco en el que se desenvuelve el espacio-tiempo bajo la acción de un campo gravitatorio, rompiendo radicalmente con la representación espacial de la física clásica. Einstein recurrió a la utilización de coordenadas gaussianas como el método adecuado a medidas -distancias- no Euclídeas, características del continuo espacio-temporal bajo el efecto de un campo gravitatorio.

La cuantificación de la energía o la Mecánica Cuántica:

Si bien la teoría de la Relatividad eliminó algunos de los presupuestos epistemológicos básicos de la física clásica, como el espacio y el tiempo absolutos, sobre los que se asentaba la representación moderna del Universo, no puso en cuestión la representación determinista de la Naturaleza característica de la época Moderna. Dicha representación se asentaba en la validez universal del principio de causalidad clásico, cuyas premisas no quedaban afectadas por la revolución relativista. Lo que salvaguardaba la vigencia del criterio de realidad dominante en la física moderna, mediante el cual era posible aprehender la naturaleza de los procesos físicos sin interferencias del observador, postulado básico de la teoría del conocimiento desarrollada en la época Moderna.

Sin embargo, este pilar fundamental del Saber moderno pronto se vería afectado por una profunda crisis, como consecuencia del desarrollo de la Mecánica Cuántica. El inicio de esta fractura epistemológica se sitúa en la introducción del "cuanto de energía" por Max Planck en 1900, resultado de su investigación sobre el problema de la radiación del cuerpo negro.

Con ello introdujo el cuanto de energía como una realidad física, al subdividir el continuo de energía en elementos de tamaño finito, un paso que rompía radicalmente con la física del siglo XIX, al introducir la discontinuidad en la emisión y absorción de energía, hecho del que no se percató el propio Planck cuando estableció su teoría de la radiación del cuerpo negro, y que tardaría en reconocer cerca de diez años por la repugnancia epistemológica que ello le producía.

La fórmula de Planck por la que se establecía una igualdad entre la energía concebida como discontinua y la energía considerada continua, en función del carácter ondulatorio de la frecuencia, resultaba completamente extraña para los físicos de la época.

La fórmula de Planck por la que se establecía una igualdad entre la energía concebida como discontinua y la energía considerada continua, en función del carácter ondulatorio de la frecuencia, resultaba completamente extraña para los físicos de la época.

Sólo Einstein comprendería el problema en toda su magnitud, al postular en 1905 la existencia de partículas(2) de luz -fotones-, y con ello establecer el carácter corpuscular y ondulatorio de la luz. Una posición que gozó de la animadversión del resto de los físicos, entre ellos el propio Planck, que atrapados por la teoría ondulatoria de la luz, dominante desde la segunda mitad del siglo XIX, no podían concebir un comportamiento a primera vista tan contrario a los postulados de la física. Tan sólo en 1922, con la introducción del efecto Compton y el desarrollo de la Mecánica Cuántica a partir de 1926-27, la solución propuesta por Einstein se abrió camino.

Fue Ehrenfest el primero en señalar que la teoría de Planck constituía una ruptura con la teoría clásica, al limitar la energía de cada modo de vibración a múltiplos enteros del elemento de energía establecido por la realidad física del cuanto de acción, señalando que la cuestión fundamental de la teoría de Planck radicaba en el tratamiento probabilístico del campo. A conclusiones similares, pero por caminos distintos, llegó Einstein en las mismas fechas, al defender que durante la absorción y la emisión la energía de un resonador cambia discontinuamente en un múltiplo entero.

Los experimentos de Frank y Hertz de 1914 demostraron que la cuantización de los niveles de energía de los átomos constituía una propiedad de la materia muy general, incompatible con la teoría corpuscular clásica de la materia, pues para ésta última la energía en un sistema de corpúsculos clásicos es una magnitud continua

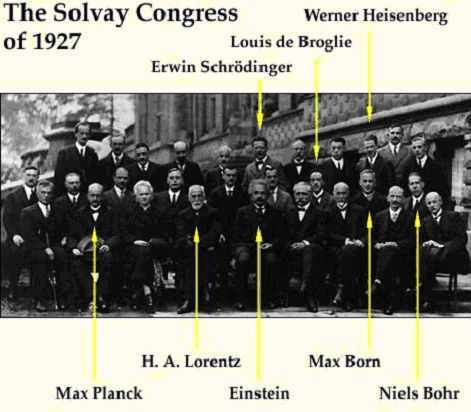

La publicación de un artículo de Heisenberg en 1925 representó un salto cualitativo en la resolución de los problemas que aquejaban a la teoría cuántica del átomo de Bohr, al proponer la necesidad de abandonar el concepto clásico de órbita electrónica e introducir un nuevo formalismo matemático, que sería desarrollado inmediatamente por Max Born y Pascual Jordan, consistente en la aplicación de la matemática de matrices. Nacía así la mecánica matricial, sobre la que se fundaría la Mecánica Cuántica. Paralelamente, Dirac llegó a resultados similares en Cambridge.

La publicación de un artículo de Heisenberg en 1925 representó un salto cualitativo en la resolución de los problemas que aquejaban a la teoría cuántica del átomo de Bohr, al proponer la necesidad de abandonar el concepto clásico de órbita electrónica e introducir un nuevo formalismo matemático, que sería desarrollado inmediatamente por Max Born y Pascual Jordan, consistente en la aplicación de la matemática de matrices. Nacía así la mecánica matricial, sobre la que se fundaría la Mecánica Cuántica. Paralelamente, Dirac llegó a resultados similares en Cambridge.

Por las mismas fechas, 1924-1926, se desarrolló la Mecánica ondulatoria por De Broglie y Schrödinger. De Broglie generalizó la dualidad onda-corpúsculo de la luz, establecida por Einstein en 1905 para el caso del electrón, señalando que esta dualidad se encontraba íntimamente asociada a la existencia misma del cuanto de acción. Se trataba, en definitiva, de asociar al movimiento de todo corpúsculo la propagación de una onda, ligando las magnitudes características de la onda a las magnitudes dinámicas del corpúsculo, mediante relaciones en las que intervenía la constante de Planck.

Esta nueva mecánica ondulatoria fue desarrollada por Schrödinger en los primeros meses de 1926. En ella señaló que los estados estacionarios de los sistemas atómicos podían representarse por las soluciones propias de una ecuación de ondas, cuyo formalismo matemático encontraba fundamento en la solución de Hamilton respecto de la analogía formal existente entre los sistemas mecánicos y ópticos.

El Principio de Incertidumbre:

La aparición en 1927 del artículo de Heisenberg en el que introducía las relaciones de incertidumbre como un principio físico fundamental, al postular que no es posible conocer simultáneamente la posición y el impulso de una partícula, no hizo sino profundizar dicha fractura epistemológica, al romper radicalmente con la antigua pretensión de la Física Moderna de alcanzar, mediante el conocimiento completo de todos los fenómenos físicos del Universo en un instante dado, la determinación absoluta hacia el pasado y hacia el futuro del Universo, en función de la validez universal del principio de causalidad estricto, origen y fundamento de la representación determinista de la Modernidad. El artículo de Heisenberg apuntaba directamente al corazón de la vieja gran aspiración de la Física Moderna, al sostener la imposibilidad física de conocer simultáneamente con exactitud determinista la posición y el impulso de cualquier clase de partícula elemental. Según las relaciones de incertidumbre, el producto de las incertidumbres de la localización y de la cantidad de movimiento no puede ser más pequeño que el cuanto de acción de Planck, constituyendo éste un límite físico infranqueable.

El principio de incertidumbre se constituye en un principio físico fundamental que rige para el conjunto de los fenómenos, y que no es posible soslayar en los niveles de magnitudes en los que el cuanto de acción no es despreciable. El principio de incertidumbre se extiende, como principio físico fundamental, al conjunto de las relaciones físicas de las magnitudes cuánticas, y no sólo a las relaciones de incertidumbre de posición e impulso. Las consecuencias epistemológicas de las relaciones de incertidumbre alcanzaban de lleno al centro mismo de lo que había sido la Física desde los tiempos de Newton; es decir, cuestionan la capacidad de la Física para establecer leyes de la Naturaleza que determinen con absoluta precisión su funcionamiento como si de un mecanismo de relojería se tratará.

Ello provocó una fuerte polémica entre los defensores y detractores de la mecánica cuántica, centrada en el alcance de las consecuencias epistemológicas y la interpretación que debía realizarse de la nueva teoría cuántica. Polémica cuyos rescoldos todavía no se han apagado en la actualidad, si consideramos las posturas mantenidas por el neodeterminista Bunge o el realista clásico Popper, por citar sólo dos casos. La fractura era tan radical que tanto Planck como Einstein se negaron hasta su muerte a aceptar los resultados de la mecánica cuántica, al considerar que significaba el fin de la física como teoría comprensiva de la Naturaleza. En el caso de Einstein, éste mantuvo una prolongada y famosa polémica con Niels Bohr iniciada en la V Conferencia Solvay, celebrada en Bruselas en octubre de 1927, y continuada hasta su fallecimiento en 1955. De dicha polémica Einstein salió derrotado pero no vencido, y aunque terminó aceptando a su pesar la validez del formalismo de la mecánica cuántica, no cejó en su intento de demostrar que la interpretación de dicho formalismo no era correcta.

Ello provocó una fuerte polémica entre los defensores y detractores de la mecánica cuántica, centrada en el alcance de las consecuencias epistemológicas y la interpretación que debía realizarse de la nueva teoría cuántica. Polémica cuyos rescoldos todavía no se han apagado en la actualidad, si consideramos las posturas mantenidas por el neodeterminista Bunge o el realista clásico Popper, por citar sólo dos casos. La fractura era tan radical que tanto Planck como Einstein se negaron hasta su muerte a aceptar los resultados de la mecánica cuántica, al considerar que significaba el fin de la física como teoría comprensiva de la Naturaleza. En el caso de Einstein, éste mantuvo una prolongada y famosa polémica con Niels Bohr iniciada en la V Conferencia Solvay, celebrada en Bruselas en octubre de 1927, y continuada hasta su fallecimiento en 1955. De dicha polémica Einstein salió derrotado pero no vencido, y aunque terminó aceptando a su pesar la validez del formalismo de la mecánica cuántica, no cejó en su intento de demostrar que la interpretación de dicho formalismo no era correcta.

Hasta acá hemos visto una parte de lo que ha causado la crisis al modelo mecanicista, y ahora para terminar esta primera parte, podremos comprender: "por qué Dios no juega a los dados"

Einstein, en una carta dirigida a Max Born en 1926, explicitaba su repugnancia a las consecuencias de la mecánica cuántica: "la mecánica cuántica es algo muy serio. Pero una voz interior me dice que de todos modos no es ese el camino. La teoría dice mucho, pero en realidad no nos acerca gran cosa al secreto del Viejo. En todo caso estoy convencido de que El no juega a los dados." En 1957 De Broglie expresaba con claridad la validez de las consecuencias que Einstein rechazaba: "Mientras que en la física clásica era posible describir el curso de los sucesos naturales como una evolución conforme a la causalidad, dentro del marco del espacio y del tiempo (o espacio-tiempo relativista), presentando así modelos claros y precisos a la imaginación del físico; en cambio, en la actualidad la física cuántico impide cualquier representación de este tipo y, en rigor, la hace completamente imposible. Sólo permite teorías basadas en fórmulas puramente abstractas, desvirtuando la idea de una evolución causal de los  fenómenos atómicos y corpusculares; únicamente suministra leyes de probabilidad considerando que estas leyes de probabilidad son de carácter primario y constituyen la esencia de la realidad cognoscible; y no permiten que sean explicadas como consecuencia de una evolución causal que se produjera a un nivel aún más profundo del mundo físico".

fenómenos atómicos y corpusculares; únicamente suministra leyes de probabilidad considerando que estas leyes de probabilidad son de carácter primario y constituyen la esencia de la realidad cognoscible; y no permiten que sean explicadas como consecuencia de una evolución causal que se produjera a un nivel aún más profundo del mundo físico".

"Al parecer Einstein estaba doblemente equivocado cuando afirmó que "Dios no juega a los dados". Los estudios sobre la emisión de partículas desde agujeros negros permiten sospechar que Dios no solamente juega a los dados, sino que, a veces, los echa donde nadie puede verlos". Stephen W. Hawking

(1) Se denomina habitualmente Ilustración o Siglo de las luces a la corriente intelectual de pensamiento que dominó Europa y en especial Francia durante casi todo el siglo XVII y que abarca desde el Racionalismo y del Empirismo del siglo XVII hasta la Revolución Industrial del siglo XVIII, la Revolución Francesa y el Liberalismo.

(2) En física se denomina Partícula Elemental a un objeto indivisible o que compone otras partículas mayores, por ejemplo núcleos atómicos. También se denomina partícula a un cuerpo dotado de masa, y del que se hace abstracción del tamaño y de la forma, pudiéndose considerar como un Punto (Geometría). A cada una de las partículas de la naturaleza le corresponde una antipartícula que posee la misma masa y el mismo spin. Algunas partículas como el fotón, son idénticas a su antipartícula. Esas partículas no tienen carga eléctrica, pero no todas las partículas de carga neutra son de este tipo. Siempre hemos tenido la impresión de que las leyes de la naturaleza parecían haber sido diseñadas para que todo fuese simétrico entre partículas y antipartículas hasta que los experimentos de la llamada violación CP (violación carga-paridad) encontraron que la simetría temporal se violaba en ciertos sucesos de la naturaleza. El exceso observado de bariones con respecto a los anti-bariones en el universo es uno de los principales problemas sin respuesta de la cosmología. Los pares partícula-antipartícula pueden aniquilarse entre ellos si se encuentran en el estado cuántico apropiado. Estos estados pueden producirse en varios procesos. Estos procesos se usan en los aceleradores de partículas para crear nuevas partículas y probar las teorías de la física de partículas. Los procesos de altas energías en la naturaleza pueden crear antipartículas, y éstos son visibles debido a los rayos cósmicos y en ciertas reacciones nucleares. La palabra antimateria se refiere a las antipartículas elementales, los compuestos de antipartículas hechos con estas (como el antihidrógeno) y formaciones mayores que pueden hacerse con ellos.

(3) La radiación electromagnética es una combinación de campos eléctricos y magnéticos oscilantes, que se propagan a través del espacio transportando energía de un lugar a otro. A diferencia de otros tipos de onda, como el sonido, que necesitan un medio material para propagarse, la radiación electromagnética se puede propagar en el vacío. En el siglo XIX se pensaba que existía una sustancia indetectable llamada éter que ocupaba el vacío y servía de medio de propagación de las ondas electromagnéticas. El estudio teórico de la radiación electromagnética se denomina electrodinámica y es un sub-campo del electromagnetismo.

Maxwell puso juntas unas ecuaciones, actualmente denominadas ecuaciones de Maxwell, de las que se desprende que un campo eléctrico variable en el tiempo genera un campo magnético y, recíprocamente, la variación temporal del campo magnético genera un campo eléctrico. Se puede visualizar la radiación electromagnética como dos campos que se generan mutuamente, por eso no necesitan ningún medio material para propagarse. Las ecuaciones de Maxwell también predicen la velocidad de propagación en el vacío (que se representa c, por la velocidad de la luz con un valor de 299.792 km/s), y su dirección de propagación (perpendicular a las oscilaciones del campo eléctrico y magnético que, a su vez, son perpendiculares entre sí).